Die Nutzung des Tools für Fortgeschrittene

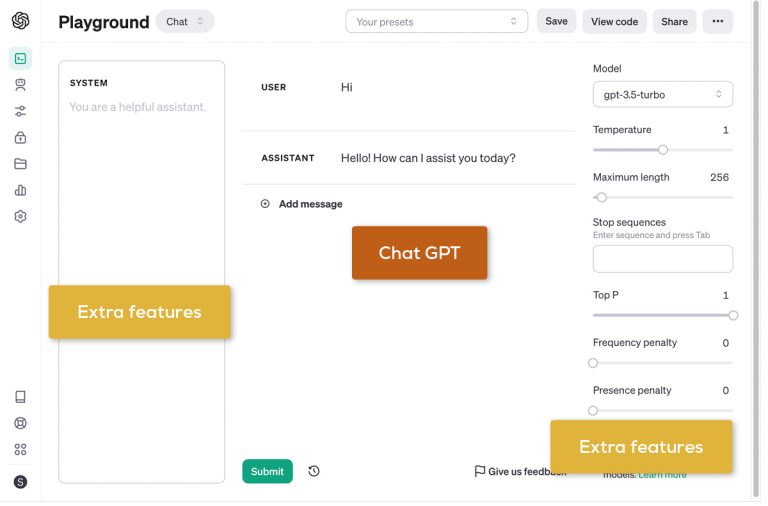

Der OpenAI Playground (dt. Spielwiese/Spielplatz) ist ein mächtiges Werkzeug, das es Nutzer/-innen und Produktteams ermöglicht, das Verhalten und die Fähigkeiten der OpenAI-Modelle präzise zu steuern und zu optimieren.

In diesem Artikel beleuchten wir fortgeschrittene Funktionen, die über das Standard-ChatGPT-Erlebnis hinausgehen und wie diese für bessere Kontrolle und Validierung von KI-basierten Anwendungen genutzt werden können.

Die OpenAI Playground-Parameter

Temperatur – die Steuerung der Kreativität

Der Parameter Temperature bestimmt, wie vorhersehbar oder variabel die Antworten der KI sind. Ein niedriger Wert führt zu konsistenteren Antworten und ein höherer Wert zu kreativeren und weniger vorhersehbaren Ausgaben. Dies ermöglicht es, die Ausgabe je nach Anwendungsfall anzupassen.

Hier sind allgemeine Richtwerte für die Einstellung der Temperatur für verschiedene Textarten:

E-Mails

Bei geschäftlichen oder formalen E-Mails ist in der Regel eine Temperatur von etwa 0 bis 0.3 empfehlenswert, um konsistente und vorhersehbare Antworten zu erzeugen, die professionell und auf den Punkt gebracht sind.Informativer Text

Für informative oder erklärende Texte, wie Artikel oder Anleitungen, könnte eine Temperatur zwischen 0.3 und 0.5 geeignet sein, um gleichzeitig Genauigkeit zu gewährleisten und zeitgleich eine minimale Kreativität für ansprechende Formulierungen zuzulassen.Kreatives Schreiben & Gedichte

Bei kreativem Schreiben oder Gedichten kann eine höhere Temperatur zwischen 0.7 und 1.0 verwendet werden. Diese ermöglicht der KI, kreative und einzigartige Inhalte zu generieren, die den Leser überraschen und emotional ansprechen können.

Es ist zu beachten, dass diese Werte nur als allgemeine Orientierung dienen und je nach spezifischen Anforderungen und Präferenzen angepasst werden sollten. Oft ist ein Experimentieren erforderlich, um die richtige Balance für individuelle Anwendungsfälle zu finden.

Tokens – die Grundeinheit

Tokens sind die grundlegenden Bausteine, die KI-Sprachmodelle wie gpt-* verwenden, um Text zu analysieren und zu generieren. Sie können als einzelne Wörter, Satzzeichen oder auch Teile von Wörtern verstanden werden. Komplexere Wörter oder Phrasen können in mehrere Tokens unterteilt werden.

Da Englisch eine sehr diverse Sprache mit vielen unterschiedlich langen Wörtern ist, wird die Länge eines Tokens nicht einfach in Wörtern gemessen, sondern ist eher mit der tatsächlichen Anzahl an Zeichen verbunden. Im Durchschnitt entspricht ein Token in englischen Texten etwa ¾ eines Wortes oder ungefähr vier Zeichen. Diese Tokenisierung ermöglicht es Sprachmodellen, Text in kleinere, verarbeitbare Teile zu zerlegen, was eine detaillierte Analyse und Generierung von Text ermöglicht.

Kontextlänge – Umgang mit Datenmengen

Die Kontextlänge gibt an, wie viel Kontext (Ein-/Ausgabe) das Modell bei der Erstellung von Antworten berücksichtigt. Dieser Wert ist entscheidend für Aufgaben, die ein umfangreiches Verständnis erfordern. GPT-4 Turbo verfügt beispielsweise über ein Kontextfenster von 128K Tokens, während das aktualisierte GPT-3.5 Turbo mit einem 16K Tokenfenster arbeitet.

Unter Verwendung der offiziellen Umrechnung von einem Token, das etwa vier Zeichen eines englischen Textes entspricht, können wir die Kontextlängen in Anzahl der A4-Seiten umrechnen.

Eine Faustregel für Standard-Englischtexte ist, dass ¾ eines Wortes einem Token entsprechen.

Wenn wir davon ausgehen, dass eine durchschnittliche A4-Seite etwa 250 Wörter umfasst und jedes Wort in etwa vier Zeichen oder ¾ eines Tokens entspricht, können wir folgende Rechnung aufstellen:

Eine A4-Seite = 250 Wörter = 250 / (¾) Tokens ≈ 333 Tokens

Mit dieser Umrechnung ergibt sich:

GPT-4 Turbo

Mit einem Kontextfenster von 128.000 Tokens könnten theoretisch 128.000/333 ≈ 384 A4-Seiten an Kontext verarbeitet werden.GPT-3.5 Turbo

Mit einem Kontextfenster von 16.000 Tokens könnten theoretisch 16.000/333 ≈ 48 A4-Seiten an Kontext verarbeitet werden.

Beim Arbeiten mit aktuellen KI-Modellen und ihren Kontextfenstern ist es wichtig zu beachten, dass sich diese Modelle zwar an große Mengen von Text auf einmal „erinnern“ können, aber die Art und Weise, wie sie ihre Aufmerksamkeit auf diesen Text verteilen, variiert.

Das Kontextfenster definiert die Textmenge, die das Modell jeweils im Gedächtnis behalten kann, während der Mechanismus der Aufmerksamkeit innerhalb dieses Fensters bestimmt, wie das Modell verschiedene Teile des Textes verarbeitet und priorisiert, um Antworten zu generieren. Die Aufmerksamkeitsspanne bezieht sich mehr auf die Qualität und den Fokus der Verarbeitung innerhalb des gegebenen Kontextfensters.

Um diese Unterscheidung besser zu verstehen, kann man sich das Beispiel eines 6-jährigen Kindes vorstellen:

„Geh nach oben, putze deine Zähne, wasche dein Gesicht, zieh deinen Schlafanzug an, mach das Licht im Badezimmer aus, wenn du fertig bist, und bring dein Lieblingsbuch mit herunter, damit wir es gemeinsam lesen können. Vergiss außerdem nicht, die Zahnpastatube zuzumachen!“

Ein Kind könnte sicherlich die gesamte Aufgabenstellung, also das „Kontextfenster“, verstehen, aber seine „Aufmerksamkeitsspanne“ könnte überstrapaziert werden. Es ist möglich, dass es die ganze Serie von Schritten ohne Fehler ausführt, aber es ist auch möglich (vielleicht sogar wahrscheinlich), dass einige Anweisungen übersehen werden.

Ähnlich kann es bei KI-Modellen passieren, dass Inhalte, die in der Mitte eines langen Kontexts stehen, weniger Beachtung finden und bei der Generierung von Antworten im Vergleich zum Anfang oder Ende des Kontexts unterrepräsentiert sind. Daraus resultiert, dass die Qualität und Konsistenz der Antworten variieren kann, besonders wenn der relevante Inhalt über ein langes Kontextfenster verteilt ist.

Modellauswahl – Passend für den Anwendungsfall

Die Wahl des richtigen Modells hängt von der spezifischen Aufgabe ab. OpenAI bietet verschiedene Modelle mit unterschiedlichen Fähigkeiten:

GPT-3.5-Turbo: Ist das kosteneffizienteste Modell in der GPT-3.5-Familie und optimiert für Chat-Anwendungen, allerdings auch geeignet für traditionelle Komplettierungsaufgaben.

GPT-4: Als großes multimodales Modell (akzeptiert Text- und Bildeingaben und gibt Text aus) löst es schwierige Probleme mit höherer Genauigkeit dank seines umfassenderen Allgemeinwissens und fortgeschritteneren Schlussfolgerungsfähigkeiten.

GPT-4 Turbo: Verfügt über die Fähigkeiten von GPT-4, jedoch mit Verbesserungen bei der Anleitungsbefolgung, mehr reproduzierbaren Ausgaben und höherer Kontextlänge

Die Wahl des Modells sollte auf Grundlage der Komplexität der Aufgabe, der benötigten Multimodalität und der Fähigkeit, Anweisungen zu folgen, getroffen werden.

Nachrichtentypen – User, AI, System

Der Playground bietet zusätzlich unterschiedliche Nachrichtentypen für die Eingabe:

User: Simuliert die Eingabe eines Nutzers an die KI.

AI: Zeigt die Antwort der KI auf die Nutzereingabe.

System: Systemnachrichten, die für Steuerungsaufgaben oder spezifische Anweisungen/Konfiguration an das Modell verwendet werden können.

Durch die Verwendung des Nachrichtentyps „System“ kann ein Entwickler das Modell so konfigurieren, dass es nur in einem bestimmten Format – wie JSON oder XML – antwortet. Dies ist besonders nützlich, wenn das KI-Modell als API für strukturierte Daten genutzt werden soll oder wenn spezifische Eingabeparameter abgefragt werden.

Beispiel

Temperatur: 0.7

Systemnachricht:

# Behaviour

You are an api and can only response with valid, directly parsable json.

Your Output-JSON must be baseed on this jsonschema:

{

"$schema": "http://json-schema.org/draft-07/schema#",

"type": "object",

"title": "Todo Task",

"required": ["task", "description"],

"properties": {

"task": {

"type": "string",

"description": "The title of the task"

},

"description": {

"type": "string",

"description": "Additional details about the task"

}

}

}

Ausgabe:

{ "task": "Complete assignment",

"description": "Finish the API assignment by the deadline" }

Diese Methode ist keineswegs auf einfache Strukturen limitiert. Meine Erfahrung zeigt, dass selbst sehr umfangreiche und komplizierte JSON-Strukturen generiert werden können, wenn das Schema präzise erläutert ist. In 99 Prozent der Fälle sind die Ergebnisse valide. Die nächsten Artikel dieser Serie werden solche komplexen Beispiele näher beleuchten.

Preismodell und Kosteneffizienz

Die Kosten werden nach der Anzahl der verarbeiteten Tokens berechnet, wodurch eine direkte Kontrolle über die Nutzung und den damit verbundenen Preis entsteht. Indem man verschiedene Parameter und Modelle in der Spielwiese testet, kann man die Kosten sofort einschätzen und das Preis-Leistungs-Verhältnis optimieren.

Durch das Verständnis und die Anpassung dieser Parameter ermöglicht der OpenAI Playground eine feingranulare Steuerung der KI-Interaktionen, wodurch die Integration von KI in Produkte und Dienste nicht nur effektiver, sondern auch kosteneffizienter gestaltet werden kann.

Links & further reading:

Alptuğ Dingil

Alptuğ unterstützt uns bereits seit 2022 im Bereich Softwareentwicklung. Neben den Kundenprojekten sucht er immer wieder nach neuen Herausforderungen und beschäftigte sich in jüngster Zeit mit Kubernetes und der Konfiguration eines DIY-Clusters. Außerdem ließ er sich von Google als Professional Cloud Architect zertifizieren.